数据湖存储格式Hudi 原理、实践与数据处理存储服务支持

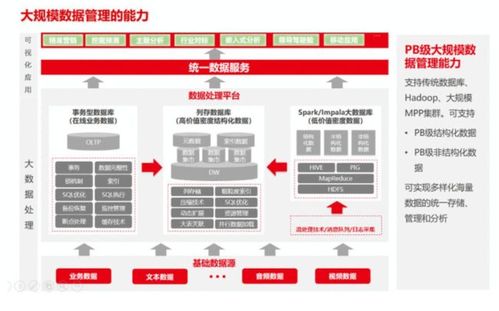

随着大数据技术的飞速发展,数据湖已成为企业数据架构的核心组成部分。它旨在存储海量的原始数据,支持多种数据类型和处理范式。在数据湖的构建中,存储格式的选择至关重要,它直接影响到数据的查询效率、更新能力、事务支持以及存储成本。Apache Hudi(Hadoop Upserts Deletes and Incrementals)作为一种先进的数据湖存储格式,以其对增量数据处理、近实时摄取和高效更新/删除操作的原生支持,在业界获得了广泛应用。本文将深入探讨Hudi的核心原理,分享其实践经验,并阐述其在数据处理与存储支持服务中的关键作用。

一、Hudi的核心原理

Hudi的设计哲学是解决传统大数据存储格式(如Parquet、ORC)在支持更新、删除和增量处理方面的不足。其核心原理围绕以下几个方面构建:

- 表类型与查询类型:Hudi定义了两种主要的表类型——Copy-on-Write(COW)和Merge-on-Read(MOR)。

- COW表:在写入时,通过创建包含更新/删除记录的新数据文件副本来实现数据修改。查询时直接读取最新的数据文件,因此读取性能最佳,但写入延迟相对较高,适合读多写少的场景。

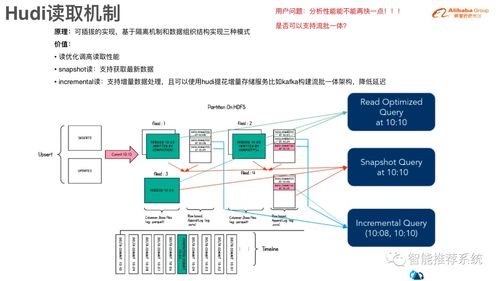

- MOR表:写入时,更新和删除操作被记录到增量日志文件中,而基础数据文件保持不变。查询时需要合并基础文件和增量日志来提供最新视图。这种设计实现了低延迟的写入和高吞吐量的批量读取,适合写多读少的场景。

- 时间线(Timeline):这是Hudi的元数据核心,按时间顺序记录了在数据集上执行的所有操作(如提交、清理、压缩)。它提供了数据集的原子性视图,并支持时间旅行查询,允许用户查询某个历史时间点的数据快照。

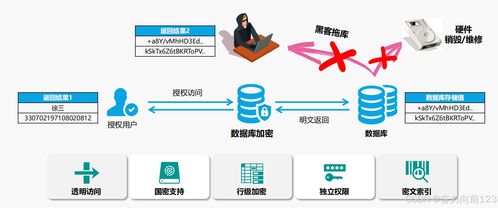

- 索引机制:Hudi提供了多种索引类型(如布隆过滤器索引、HBase索引、自定义索引),用于在写入时快速定位一条记录所在的数据文件。这是高效实现Upsert和Delete操作的关键,避免了为更新少量记录而全表扫描的成本。

- 文件布局与压缩:Hudi将数据组织成文件组(File Group),每个文件组包含一个基础数据文件和多个增量日志文件(MOR表)。定期的压缩操作会将增量日志合并到基础文件中,优化存储和读取性能。

二、Hudi的实践应用

在实践中,Hudi能够有效解决诸多数据工程挑战:

- 近实时数据摄取:通过流式处理引擎(如Apache Spark Structured Streaming, Apache Flink)可以将Kafka等消息队列中的数据以极低延迟(分钟级甚至秒级)写入Hudi表,构建近实时数据湖。

- 增量ETL与CDC:Hudi原生支持增量查询,能够高效地识别出自上次处理以来发生变化的数据。这极大地简化了变更数据捕获(CDC)场景下的ETL管道,只需处理增量数据而非全量数据,节省了大量计算资源。

- 支持更新与删除:对于需要符合GDPR等数据隐私法规,或业务本身需要修正历史数据的场景,Hudi提供了对记录级更新和删除的操作支持,这是许多传统数据湖格式难以做到的。

- 统一批流存储:Hudi表可以同时作为批处理和流处理作业的源与目标,实现了存储层的批流一体,简化了架构。

典型的技术栈集成包括:使用Apache Spark或Fink进行数据写入与处理,使用Presto/Trino、Hive或Spark SQL进行交互式查询,并利用Hudi的元数据同步功能与Hive Metastore集成,使得现有工具可以无缝访问Hudi表。

三、作为数据处理和存储支持服务的关键组件

在企业级数据平台中,Hudi扮演着至关重要的数据处理与存储支持服务角色:

- 提供高效、弹性的存储服务:通过COW和MOR两种表类型,Hudi服务可以根据不同的SLA(服务水平协议)要求(读取延迟 vs 写入延迟)提供差异化的存储方案。其自动的文件管理(清理、归档、压缩)功能降低了运维成本。

- 赋能数据管道服务:作为数据管道的关键一环,Hudi服务提供了可靠的、具有事务保证的数据接收端点。其增量处理能力使得下游的数据转换、建模和聚合作业能够以增量方式运行,构建高效、低延迟的数据流水线。

- 支持数据治理与质量:时间旅行功能为数据审计、回滚和重复计算提供了基础。更新/删除能力直接支持了数据纠错和合规性要求,提升了数据湖的数据质量和可信度。

- 优化计算资源与成本:通过增量处理模式,大幅减少了不必要的数据扫描和计算,直接降低了计算集群的资源消耗和云上成本。高效的列式存储格式(底层通常为Parquet)也优化了存储成本。

结论

Apache Hudi通过创新的存储格式设计,有效弥合了传统数据仓库与数据湖之间的能力鸿沟,为大数据生态系统带来了急需的更新、删除和增量处理能力。理解和掌握Hudi的原理,并成功将其集成到数据架构的实践中,能够帮助企业构建更实时、更高效、更易维护的数据湖,从而为上层的数据分析、机器学习和实时应用提供强大的数据存储与处理支持服务。随着数据实时性需求的日益增长,Hudi及其代表的技术方向将继续在数据湖的演进中扮演核心角色。

如若转载,请注明出处:http://www.kjifkj.com/product/51.html

更新时间:2026-03-01 02:02:26